OpenAI โอเพนโมเดลใหม่ที่จะเร่งความเร็วภายในเครื่องบน GPU NVIDIA GeForce RTX และ RTX PRO : Page 1 (1/1)

.

NVIDIA ร่วมมือกับ OpenAI ปรับปรุงโมเดล gpt-oss แบบโอเพนซอร์สใหม่ของบริษัทให้เหมาะสมกับ GPU ของ NVIDIA มอบการคาดคะเนอย่างมีหลักการตามข้อมูลทีมีอย่างชาญฉลาดและรวดเร็วจากคลาวด์ไปยังพีซี โมเดลความสามารถของ AI ในการวิเคราะห์ปัญหาที่ยุ่งยากเหล่านี้ช่วยให้สามารถใช้งานแอปพลิเคชัน AI การใช้เหตุผลที่ซับซ้อนและการวางแผนแบบวนซ้ำเพื่อแก้ไขปัญหาที่ซับซ้อนโดยอัตโนมัติเช่น การค้นหาเว็บ การวิจัยเชิงลึก และอื่นๆ อีกมากมาย

.

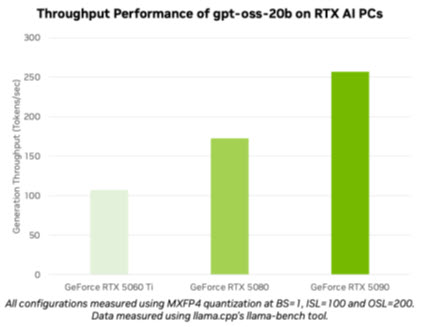

ด้วยการเปิดตัว gpt-oss-20b และ gpt-oss-120b OpenAI ได้เปิดโมเดลล้ำสมัยให้กับผู้ใช้หลายล้านคน ผู้ที่ชื่นชอบ AI และนักพัฒนาสามารถใช้โมเดลที่ปรับแต่งแล้วบนพีซีและเวิร์กสเตชัน NVIDIA RTX AI ผ่านเครื่องมือและเฟรมเวิร์กยอดนิยมอย่าง Ollama, llama.cpp และ Microsoft AI Foundry Local และคาดว่าจะมีประสิทธิภาพสูงสุด 256 โทเค็นต่อวินาทีบน GPU NVIDIA GeForce RTX 5090

.

เจนเซ่น ฮวง ผู้ก่อตั้งและซีอีโอของ NVIDIA กล่าวว่า “OpenAI แสดงให้โลกเห็นถึงสิ่งที่สามารถสร้างขึ้นบน NVIDIA AI ได้ และตอนนี้พวกเขากำลังพัฒนานวัตกรรมในซอฟต์แวร์โอเพนซอร์ส” “โมเดล gpt-oss ช่วยให้นักพัฒนาทุกที่สามารถสร้างบนรากฐานโอเพ่นซอร์สที่ล้ำสมัย เสริมสร้างความเป็นผู้นำด้านเทคโนโลยี AI ของสหรัฐฯ ทั้งหมดนี้บนโครงสร้างพื้นฐานการประมวลผล AI ที่ใหญ่ที่สุดในโลก”

.

การเปิดตัวโมเดลดังกล่าวเน้นย้ำถึงความเป็นผู้นำด้าน AI ของ NVIDIA ตั้งแต่การฝึกอบรมไปจนถึงการคาดคะเนอย่างมีหลักการตามข้อมูลทีมี และจากคลาวด์ไปจนถึง AI PC

.

Open for All

.

ทั้ง gpt-oss-20b และ gpt-oss-120b เป็นแบบจำลองการให้เหตุผลแบบเปิดที่ยืดหยุ่น มีความสามารถในการวิเคราะห์แบบลำดับความคิด และระดับความพยายามในการให้เหตุผลที่สามารถปรับได้ โดยใช้สถาปัตยกรรมแบบผสมผสานของผู้เชี่ยวชาญที่ได้รับความนิยม แบบจำลองเหล่านี้ออกแบบมาเพื่อรองรับฟีเจอร์ต่างๆ เช่น การปฏิบัติตามคำสั่ง และการใช้เครื่องมือ และได้รับการฝึกอบรมบน GPU NVIDIA H100 นักพัฒนา AI สามารถเรียนรู้เพิ่มเติมและเริ่มต้นใช้งานได้โดยใช้คำแนะนำจากบล็อกทางเทคนิคของ NVIDIA

.

โมเดลเหล่านี้สามารถรองรับความยาวบริบทได้สูงสุดถึง 131,072 ความยาว ซึ่งเป็นหนึ่งในความยาวของกระบวนการที่ยาวที่สุดที่มีอยู่ในการสรุปภายใน ซึ่งหมายความว่าโมเดลเหล่านี้สามารถให้เหตุผลผ่านปัญหาในกระบวนการได้ ซึ่งเหมาะอย่างยิ่งสำหรับงานต่างๆ เช่น การค้นหาเว็บ การช่วยเหลือในการเขียนโค้ด การทำความเข้าใจเอกสาร และการค้นคว้าเชิงลึก

.

OpenAI เป็นโมเดล MXFP4 แรกที่รองรับบน NVIDIA RTX MXFP4 ช่วยให้ได้คุณภาพโมเดลสูง ให้ประสิทธิภาพที่รวดเร็วและมีประสิทธิภาพ ขณะเดียวกันก็ใช้ทรัพยากรน้อยกว่าเมื่อเทียบกับโมเดลความแม่นยำประเภทอื่น

.

รันโมเดล OpenAI บน NVIDIA RTX ด้วย Ollama

.

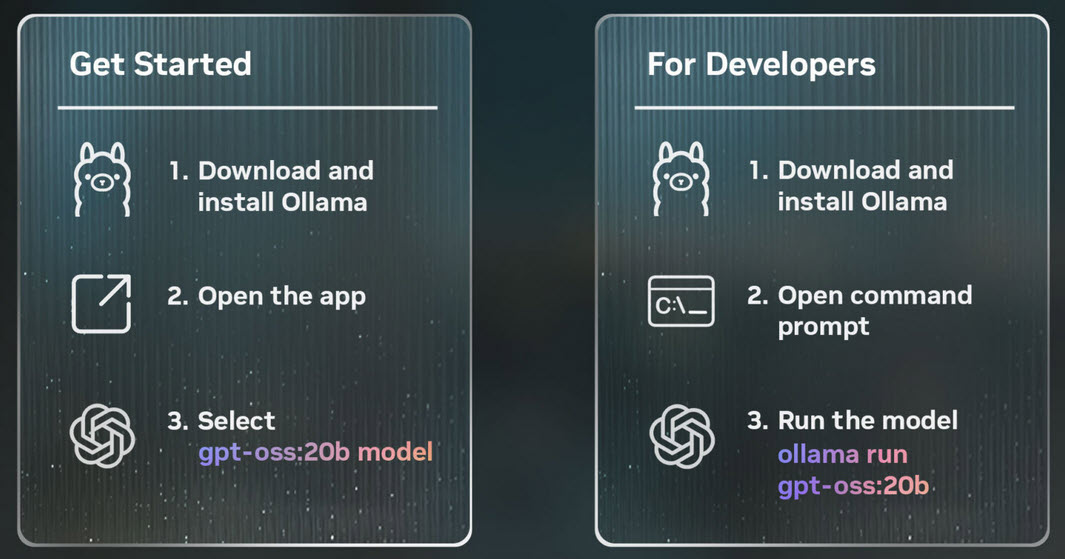

วิธีที่ง่ายที่สุดในการทดสอบโมเดลเหล่านี้บนพีซี RTX AI ด้วย GPU ที่มี VRAM อย่างน้อย 24GB คือการใช้แอป Ollama ใหม่นี้ app Ollama ได้รับความนิยมในหมู่ผู้ที่ชื่นชอบ AI และนักพัฒนาเนื่องจากใช้งานง่าย และอินเทอร์เฟซผู้ใช้ (UI) ใหม่ยังรองรับโมเดล open weight ของ OpenAI ได้ทันที Ollama ได้รับการปรับแต่งให้เหมาะกับ RTX อย่างสมบูรณ์แบบ จึงเหมาะอย่างยิ่งสำหรับผู้บริโภคที่ต้องการสัมผัสพลังของ AI ส่วนบุคคลบนพีซีหรือเวิร์กสเตชัน

.

เมื่อติดตั้งแล้ว Ollama จะช่วยให้สามารถแชทกับโมเดลต่างๆ ได้อย่างรวดเร็วและง่ายดาย เพียงเลือกโมเดลจากเมนูแบบเลื่อนลงและส่งข้อความ เนื่องจาก Ollama ได้รับการปรับแต่งให้เหมาะสำหรับ RTX จึงไม่จำเป็นต้องกำหนดค่าหรือคำสั่งเพิ่มเติมใดๆ เพื่อให้มั่นใจถึงประสิทธิภาพสูงสุดบน GPU ที่รองรับ

แอปใหม่ของ Ollama มาพร้อมกับฟีเจอร์ใหม่ๆ อื่นๆ เช่น รองรับไฟล์ PDF หรือข้อความภายในห้องแชทได้อย่างง่ายดาย รองรับหลายโหมดบนโมเดลที่เกี่ยวข้องเพื่อให้ผู้ใช้สามารถใส่รูปภาพลงในคำเตือนได้ และปรับแต่งความยาวของเนื้อหาได้อย่างง่ายดายเมื่อทำงานกับเอกสารหรือห้องแชทขนาดใหญ่ นักพัฒนาซอฟต์แวร์ยังสามารถใช้ Ollama ผ่านอินเทอร์เฟซ command line หรือชุดพัฒนาซอฟต์แวร์ (SDK) ของแอปเพื่อขับเคลื่อนแอปพลิเคชันและเวิร์กโฟลว์ของพวกเขา

.

วิธีอื่นๆ ในการใช้โมเดล OpenAI ใหม่บน RTX

.

ผู้ที่ชื่นชอบและนักพัฒนาสามารถทดลองใช้โมเดล gpt-oss บนพีซี RTX AI ได้ด้วยแอปพลิเคชันและเฟรมเวิร์กอื่นๆ ทั้งหมดขับเคลื่อนโดย RTX บน GPU ที่มี VRAM อย่างน้อย 16GB NVIDIA ยังคงร่วมมือกับชุมชนโอเพนซอร์สทั้งบน llama.cpp และไลบรารี GGML tensor เพื่อเพิ่มประสิทธิภาพการทำงานบน GPU RTX ผลงานล่าสุดประกอบด้วยการนำ CUDA Graphs มาใช้เพื่อลดโอเวอร์เฮด และการเพิ่มอัลกอริทึมที่ช่วยลดโอเวอร์เฮดของ CPU ลองดูที่คลัง llama.cpp GitHub เพื่อเริ่มต้นใช้งาน

นักพัฒนาระบบ Windows ยังสามารถเข้าถึงโมเดลใหม่ของ OpenAI ได้ผ่าน Microsoft AI Foundry Local ซึ่งขณะนี้อยู่ในเวอร์ชันตัวอย่างสาธารณะ Foundry Local เป็นวิธีการแก้ปัญหาโดยการคาดคะเนอย่างมีหลักการตามข้อมูล AI บนอุปกรณ์ที่ผสานรวมเข้ากับเวิร์กโฟลว์ผ่าน command line SDK หรืออินเทอร์เฟซการเขียนโปรแกรมแอปพลิเคชัน Foundry Local ใช้ ONNX Runtime ที่ปรับแต่งผ่าน CUDA และรองรับ NVIDIA TensorRT สำหรับ RTX ในเร็วๆ นี้ เริ่มต้นใช้งานได้ง่ายๆ เพียงติดตั้ง Foundry Local และเรียกใช้คำสั่ง “Foundry model run gpt-oss-20b” ในเทอร์มินัล

.

การเปิดตัวโมเดลโอเพ่นซอร์สเหล่านี้ถือเป็นจุดเริ่มต้นของนวัตกรรม AI รุ่นใหม่จากผู้ที่ชื่นชอบและนักพัฒนาที่ต้องการเพิ่มการใช้เหตุผลให้กับแอปพลิเคชัน Windows ที่เร่งความเร็วด้วย AI